Définition

Il s'agit d'un fichier permettant d'indiquer aux différents moteurs de recherche ce qu'ils sont en mesure d'indexer ou pas. En effet, avant de référencer un site internet, les moteurs de recherche consultent le fichier robots.txt.

Le fichier "robots.txt" se trouve à la racine de votre site internet. En principe, ce fichier est généré automatiquement dès la création de votre site internet, cependant il est possible de le modifier selon vos besoins.

Procédure

Il s'agit d'un fichier permettant d'indiquer aux différents moteurs de recherche ce qu'ils sont en mesure d'indexer ou pas. En effet, avant de référencer un site internet, les moteurs de recherche consultent le fichier robots.txt.

Le fichier "robots.txt" se trouve à la racine de votre site internet. En principe, ce fichier est généré automatiquement dès la création de votre site internet, cependant il est possible de le modifier selon vos besoins.

Afin de pouvoir activer le fichier "robots.txt" sur votre site internet, il faut tout d'abord vous conneter à l'administration de votre site internet.

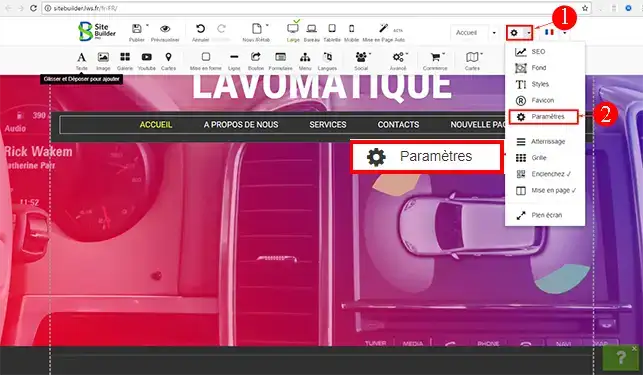

1. Cliquez sur l'onglet "Paramètres" se trouvant dans la barre d'outils de SiteBuilder Pro. Cliquez ensuite sur "Paramètres" afin d'ouvrir le panneau de configuration.

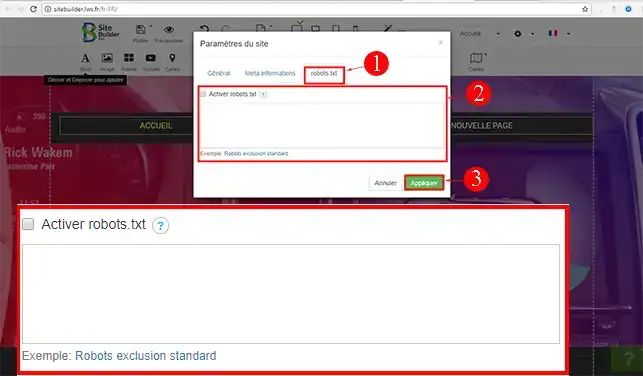

2. Rendez-vous sur l'onglet "Robots.txt" et cochez la case "Activer robots.txt".

Par défaut, si vous ne configurez rien d'autres sur votre fichier "robots.txt", ce dernier contiendra trois lignes de codes qui sont les suivantes:

A tout moment, il vous est possible de modifier le fichier "robots.txt". En effet, il se peut que vous ayez des besoins spécifiques à indiquer aux différents moteurs de recherche. Si vous désirez par exemple éviter qu'une page de votre site ne soit indexée, il vous faudra indiquer ceci sur le fichier "robots.txt"

User-Agent: googlebot Disallow: /page.html Sitemap: http://votre-domaine.com/sitemap.xml

Il est possible d'exclure plusieurs pages de l'indexation. Il suffit d'ajouter autant de lignes Disallow que voulu pour cela:

User-Agent: googlebot Disallow: /page.html Disallow: /page2.html Disallow: /page3.html Sitemap: http://votre-domaine.com/sitemap.xml

Si votre fichier "robots.txt" est conséquent, il est souvent interessant de commenter vos lignes afin de vous y retrouver:

User-Agent: googlebot Disallow: /page1.html # page de test de mon site internet Disallow /tmp # contient des fichiers temporaires

Afin de s'adresser à des moteurs de recherche spécifique, il vous faudra suivre la configuration suivante:

User-Agent: googlebot Disallow: /dossier/ User-agent: Bingbot Disallow: /dossier2/

Il est souvent conseillé, lorsque l'on est en pleine création de son site internet, d'exclure le référencement temporairement, le temps de finir la mise en place des différentes pages. Afin d'interdire l'indexation de votre site, il vous faudra insérer ce code:

User-agent: * Disallow: /

Il peut arriver de vouloir bloquer l'indexation de tout un dossier sauf un fichier qui pour vous est important. Pour celà, il vous faudra d'abord indiquer le blocage de l'indexation de tout le dossier puis autoriser l'indexation d'un ou de plusieurs fichiers se trouvant dans ce même dossier.

User-agent: googlebot Disallow: /blog/ Allow: /blog/page.html

Vous êtes désormais en mesure d'activer et paramétrer le fichier "robots.txt" sur votre site créé avec SiteBuilder Pro. Le fichier "robots.txt" permettra d'indiquer aux différents moteurs de recherche, les pages de votre site que vous désirez indexer.

N'hésitez pas à partager vos remarques et vos questions !

Pour aller plus loin

Vous êtes désormais en mesure d'activer et paramétrer le fichier "robots.txt" sur votre site créé avec SiteBuilder Pro. Le fichier "robots.txt" permettra d'indiquer aux différents moteurs de recherche, les pages de votre site que vous désirez indexer.

N'hésitez pas à partager vos remarques et vos questions !